-

- container colonna1

- Categorie

- #iorestoacasa

- Agenda

- Archeologia

- Architettura

- Arte antica

- Arte contemporanea

- Arte moderna

- Arti performative

- Attualità

- Bandi e concorsi

- Beni culturali

- Cinema

- Contest

- Danza

- Design

- Diritto

- Eventi

- Fiere e manifestazioni

- Film e serie tv

- Formazione

- Fotografia

- Libri ed editoria

- Mercato

- MIC Ministero della Cultura

- Moda

- Musei

- Musica

- Opening

- Personaggi

- Politica e opinioni

- Street Art

- Teatro

- Viaggi

- Categorie

- container colonna2

- Servizi

- Sezioni

- container colonna1

“Training Humans”. L’intelligenza artificiale alla Fondazione Prada

Arte contemporanea

-

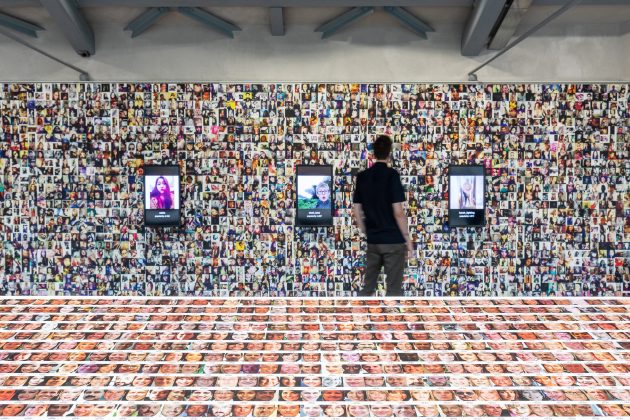

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada -

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada -

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada -

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada -

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

"Kate Crawford | Trevor Paglen: Training Humans”. Osservatorio Fondazione Prada. Photo: Marco Cappelletti. Courtesy Fondazione Prada

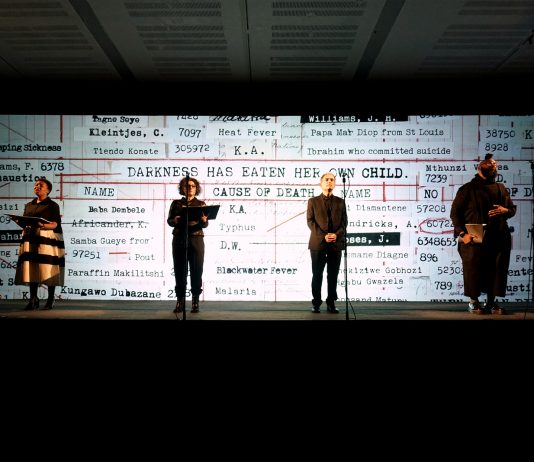

Come si addestrano i sistemi di intelligenza artificiale? Qual è il loro impatto sulla società? Sono domande più che attuali alle quali offrono (in parte) risposta Kate Crawford e Trevor Paglen con “Training Humans”, in mostra all’Osservatorio della Fondazione Prada, Milano.

È la prima grande mostra fotografica dedicata alle immagini di training. Esposti, i repertori di fotografie utilizzati per insegnare ai sistemi di intelligenza artificiale (IA) come classificare il mondo. A partire da immagini utilizzate nei primi esperimenti di riconoscimento facciale computerizzato della Central Intelligence Agency (CIA) del 1963, attraverso lo sviluppo dei sistemi più avanzati di computer vision degli anni Novanta, si passa in rassegna l’evoluzione delle collezioni di immagini da training fino a oggi. Si tratta della raccolta in database di ritratti di persone, utilizzati allo scopo di crearne una classificazione standard per fini più disparati. La recente facilità di reperibilità delle immagini, disponibili con la diffusione di internet e dei social media, ha creato perplessità circa l’utilizzo di queste immagini. Molti sono i pregiudizi ed evidenti le implicazioni politiche.

Come veniamo classificati? L’assegnazione di etichette, effettuata dai laboratori o dai dipendenti di colossi commerciali, genera classificazioni in base alla razza, all’età, alle emozioni e persino ai tratti caratteriali. Ecco che i criteri di misurazione si trasformano in strumenti di giudizio morale. Kate Crawford, ricercatrice e professoressa universitaria, studia da 15 anni l’impatto sociale e politico dell’intelligenza artificiale e dei dati su larga scala.

Tra ricostruzione storica e realizzazione del potere di tali strumenti artificiali, la mostra pone alcuni quesiti: chi può mettere in piedi questi sistemi? Chi può utilizzarli, e come? Tra rappresentazione, interpretazione e codificazione degli esseri umani, la mostra segna il punto di partenza per cominciare a comprendere come questi sistemi ci utilizzano, e – perché no – cominciare persino a interrogarci su come le nostre immagini potrebbero essere utilizzate, a meno che questo non sia già avvenuto.